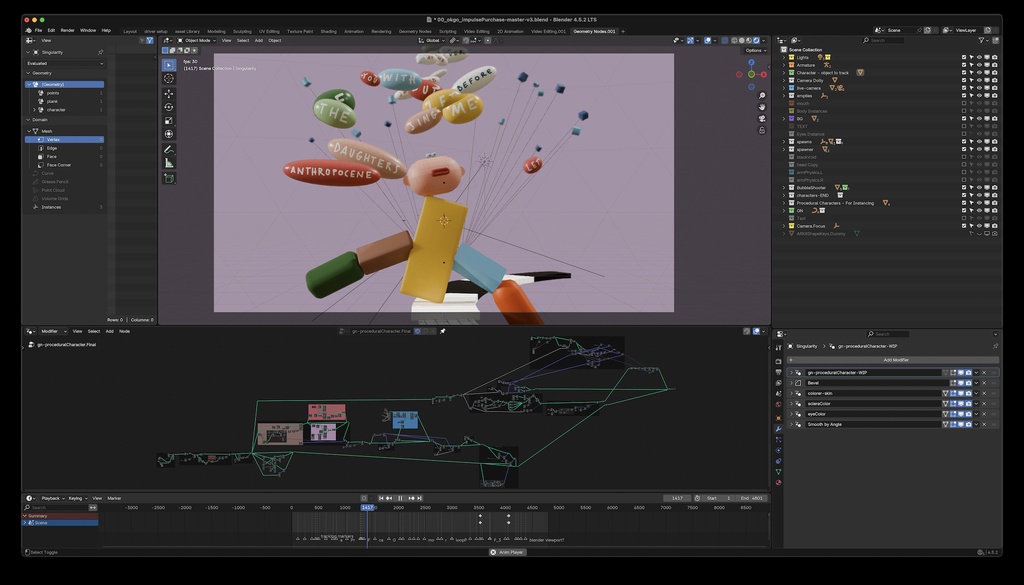

Impulse Purchase é um projeto aberto do Blender Studio. Isso significa que os arquivos de produção e recursos estão disponíveis para os assinantes do Blender Studio explorarem, analisarem e aprenderem. Dessa forma, este é um dos pontos legais que o Blender Studio proporciona para o seus assinantes acesso a vários arquivos abertos para serem analisadas explorados e estudados exaustivamente.

Impulse Purchase e seus detalhes

Antes de mais nada, todo o projeto está contido em um único arquivo .blend, que usa a viewport EEVEE e pode ser executado em tempo real.

Além disso, o personagem principal e a execução são totalmente procedurais, construídos com Geometry Nodes.

A atualização da câmera é dinâmica e muda conforme os parâmetros dos personagens mudam.

Além disso, parte da animação (boca, olhos, inclinação da cabeça) pode ser controlada por um aplicativo vinculado ao vivo via OSC.

Desempenho

Um dos objetivos da produção era construir uma configuração altamente interativa e centrada na viewport, para que o vídeo pudesse ser gravado em uma única tomada. Dessa forma, adicionando a música como uma faixa sonora no VSE, criando keyframes estratégicos para cenários, shaders e configurações de nodes, conseguimos construir uma estrutura sólida sobre a qual pudemos gravar a performance facial ao vivo. A configuração utiliza shaders simples e formas simples para atingir uma reprodução de 30 fps na viewport ao usar o EEVEE.

Configuração processual

A construção inicial do personagem principal utiliza de formas simples, seguindo a linguagem de design de Lucas Zanotto. As formas, as proporções gerais e a paleta de cores são orientadas por um conjunto de ossos, que por sua vez controlam as configurações dos Geometry Nodes. Isso permite a criação de milhares de variantes potenciais para o personagem.

Os nodes de simulação desempenham um papel importante na configuração, pois sendo utilizados para gerar bolhas, elementos de cena, lidar com membros oscilantes e também o posicionamento dinâmico da câmera em direção ao personagem.

Construir a cena da maneira mais processual possível, mas seguindo um sistema de design claro, ajudou a alcançar inúmeras variantes que parecem consistentes e tornam o vídeo muito divertido de assistir.

Animação ao vivo e marionetes

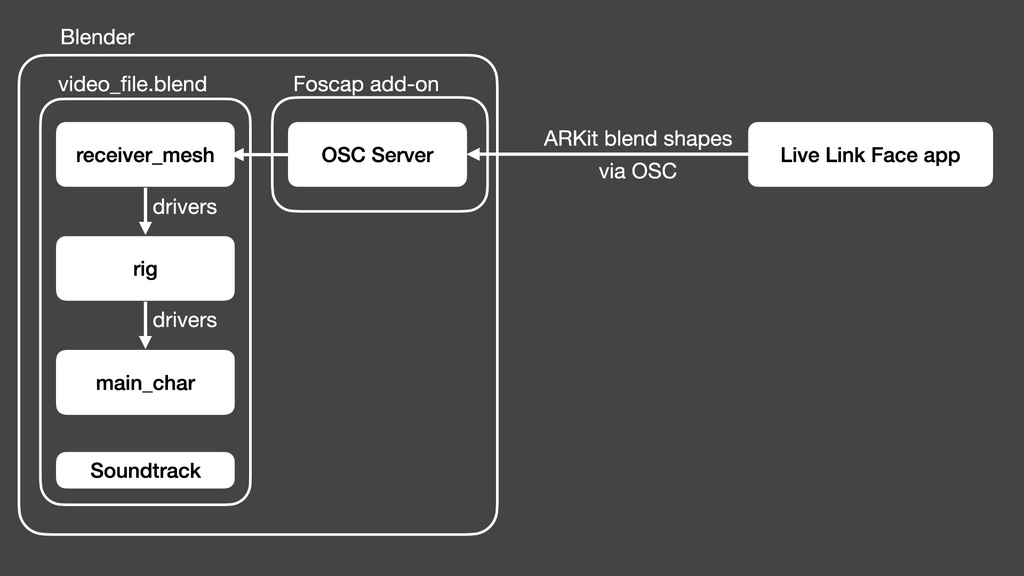

Para alcançar uma performance facial divertida do personagem principal, optamos por usar captura de movimentos ao vivo, em vez de depender de animação de keyframes. Ao desenvolver um complemento personalizado, possibilitamos a integração do Live Link Face, um aplicativo gratuito de captura de movimentos faciais, com o Blender para controlar partes da configuração procedural do personagem.

No cerne disso está o protocolo OSC (Open Sound Control). Trata-se de um protocolo de comunicação de rede bastante conhecido, usado por aplicativos para troca de dados ao vivo, geralmente no contexto de apresentações musicais.

A configuração é simples: no Blender, configuramos uma malha “receptora” com uma série de shape keys correspondentes às blendshapes do ARKit. Você então usa as shape keys para controlar os ossos que controlam a configuração dos Nós de Geometria do personagem principal. Usamos o complemento Foscap para executar um servidor OSC mínimo, que escuta o tráfego de rede e o processa para definir (ao vivo) o valor das shape keys na malha receptora.

Obtenha o arquivo demo

Baixe, abra e veja como tudo funciona. O outliner e o editor de nós são as melhores ferramentas para ajudar a navegar pela configuração e descobrir como as coisas funcionam. Este arquivo, juntamente com o complemento que permite controlar o personagem com o rosto, é gratuito para todos!

Para usar esta configuração, você precisa:

O aplicativo Live Link Face no iOS ou Android

O arquivo (veja abaixo)

okgo_impulse_purchase-demo-v005.blend

O complemento Foscap personalizado (veja abaixo)